イマーシブ・オーディオ の基礎知識と3D録音の実践:Florian Camerer氏

MIW2:イマーシブ・オーディオ概要 +フィールドレコーディング実践論

フローリアン・カメラー氏による講演。イマーシブ・システムの背景にある概念と理論について、またカメラー氏の使用する独自のマイクシステムについて詳細が紹介された。

「なぜイマーシブ・オーディオに取り組むべきなのか?」

2Dから3Dへの発展で、よりエンタテイメント性が高まる。私たちは常に360°の聴覚を持っているため、それを表現するのは至極自然な流れである。例えば、近い将来、電気自動車の普及による静音化、そして、自動運転が搭載された車内では、イマーシブ・コンテンツを日常的に楽しむ世界がくるだろう。

MI7グループ主催のセミナーイベント「Media Innovation Workshop vol.2」

「最先端の音響で、全てのビジネスを一歩先へ。」

第2回目となる2019年5月、イマーシブ・オーディオ(立体音響・没入型サラウンド)に関するワークショップが国内3箇所で開催された。

現在、音楽だけなく様々な業界でニーズが高まっている「イマーシブ・オーディオ」。今回は、イマーシブの現場の最前線で世界的に活躍される3名が登壇された。

ORFオーストリア放送協会のフローリアン・カメラー氏、”サラウンド将軍” Mick沢口氏、そして、日本初のAmbisonicsアルバム制作者 江夏正晃氏。各講師より、イマーシブに関連する基礎知識や録音/再生技術、また制作した作品の紹介や、より実践的なノウハウについてお話し頂いた。

講師

フローリアン・カメラー

ORFオーストリア放送協会 サウンド・エンジニア

EBU PLOUDグループ 代表

AES(Audio Engineering Society) メンバー

ウィーン・ニューイヤーコンサートの録音エンジニアとしても活躍。1990年にオーストリア放送協会(ORF)に入社。1995年、プロダクションサウンドとポストプロダクションの分野でスタッフサウンドエンジニア(トーンマイスター)として就任。彼はDolby Surroundにおける初のORFプログラム “Arctic Northeast”をミックスし、以降ORFでのマルチチャンネルオーディオの各方面に携わる。 2008年秋、EBUグループPLOUDの議長に着任。ヨーロッパで、ピークレベリングの代わりとなるラウドネス正規化の導入に成功する。現在、特にイマーシブ・オーディオ(3Dオーディオ)を含むラウドネスとサラウンド音響に関するプレゼンと講演を、国際的に行っている。

目次

セッションの始めに、さっそく楽曲を視聴。カメラー氏が4-5年プロデュースしている「ウィーンフィル・ニューイヤーコンサート」の3D録音が、映像付きの9.0chで再生され、まるで自分がニューイヤーコンサートの会場にいるかのような、包み込むような臨場感。その圧倒的な没入感から、ワークショップはスタートした。

曲目:ラデツキー行進曲(ヨハン・シュトラウス1世 作曲)

収録場所:ウィーンフィル・ニューイヤーコンサート(ウィーン楽友協会 大ホール)

フォーマット:Auro 3D(9.0ch / Blu-ray Disc)

Blu-ray詳細

https://www.sonymusic.co.jp/PR/new-years-concert/discography/SIXC-20

イマーシブ・オーディオのアプローチとフォーマット

イマーシブ・オーディオの方法論は、大きく分けて2種類あり、それぞれの方法論において様々なカテゴリーによるアプローチが可能となる。

1.音響心理学に基づいたアプローチ

- チャンネル・ベース

- オブジェクト・ベース

2.物理的な音場再構築に基づいたアプローチ

- シーン・ベース

- 波面合成

- バイノーラル

その中でも一般的なものは「チャンネル・ベース」「オブジェクト・ベース」「シーン・ベース」の3種類。

それぞれ異なる手法について、「制作(Production)→配信(Distribution)→再生(Playback)」それぞれの段階における違いを解説する。

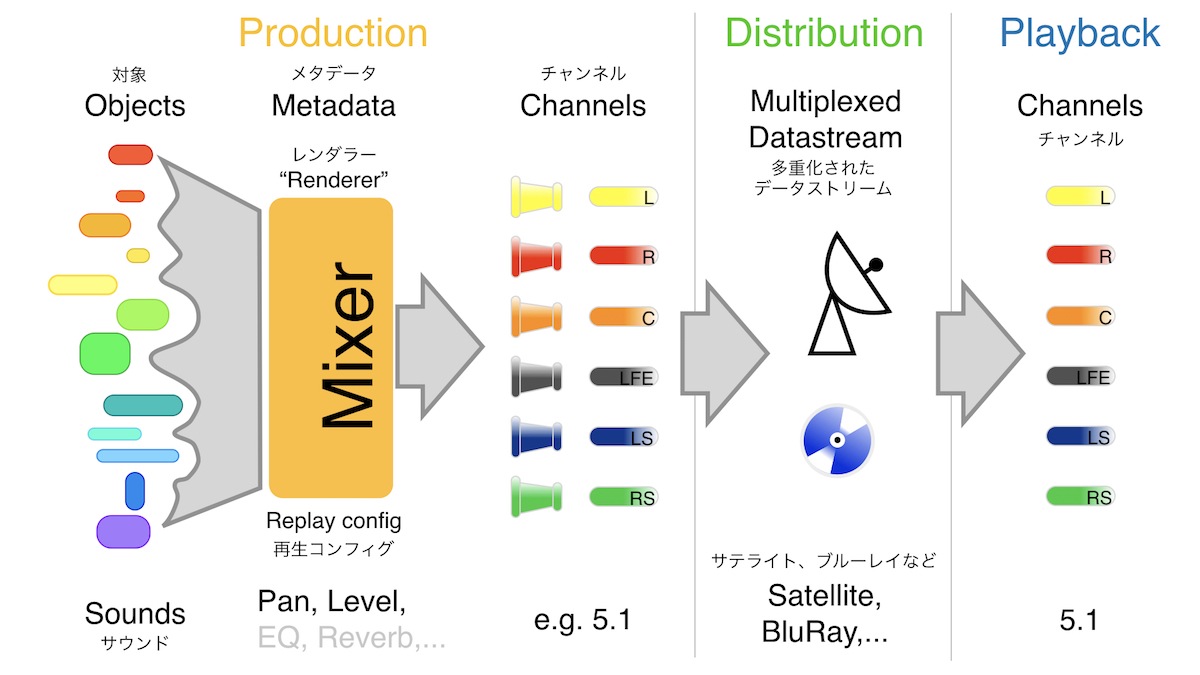

【A】チャンネル・ベース

オーディオ・ファイルがそれぞれの再生チャンネルに紐づいた形式。長年の歴史を持つフォーマットであり、近年まで盛んに行われてきた2ch形式の録音・ミックスや、5.1や7.1サラウンドのミックスは、すべてこのチャンネル・ベースである。制作(Production)の段階で、再生時(Playback)の形式、つまり「スピーカーの本数や配置」を決める必要があるということが最大の特徴となり、再生時のスピーカー配置に添うように、必要に応じて、ステレオミックス、サラウンドミックス、イマーシブミックスと、異なるミックスを複数制作しなくてはならない。

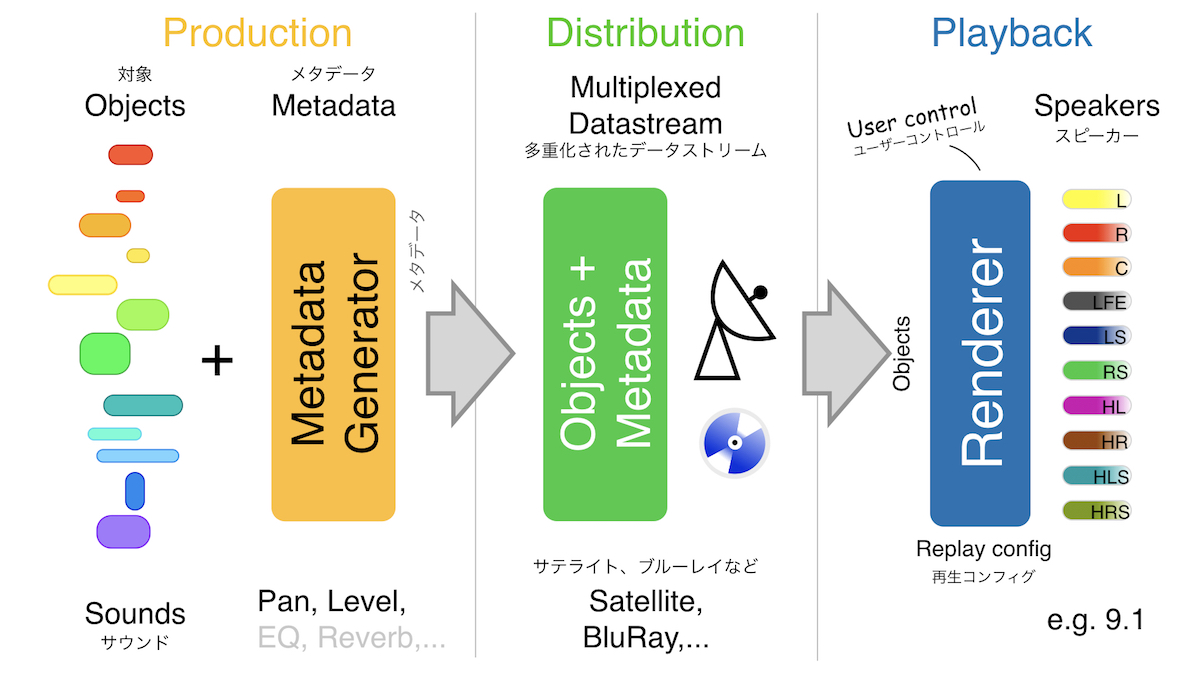

【B】オブジェクト・ベース

チャンネル・ベースとは異なり、オブジェクト・ベースでは、オーディオ・データとメタ・データが制作(Production)ステージでレンダリングされないのが特徴である。収録したオーディオ・データは、ミックスの段階にて発生するパンニングやレベルなど様々なメタ・データとは異なるデータとして個別に保存される。つまり、制作(Production)の段階で再生(Playback)時のスピーカーの本数や配置を決定しておく必要が無い。これがチャンネル・ベースとの最大の違いと言える。

そしてデータは、そのままオーディオ・ファイル/メタ・データと別れた状態で配信(Distribution)される。そして、再生ステージにデータが届くと、ここで初めてレンダリングが行われ、再生時の環境(スピーカー配置など)に合わせて適切な処理(レンダリング)が施され、各スピーカーに音声が送られるという流れだ。

再生時に初めてレンダリングされることにより生まれる「User Control」が、オブジェクト・ベース最大の利点といえる。

従って、オブジェクト・ベースでの制作はでは、ひとつの演目(録音)に対して、2ch/5.1ch/9.1chミックスと、再生時のユーザー環境に添うように異なるミックスを複数制作する必要がない。チャンネル・ベースとは異なり、Productionステージで制作するのは一種類のミックスのみである。ただし、その代わりに再生時にはオーディオ・データとメタ・データをレンダリングする「レンダラー」が必要となり、ユーザーは、それに対応したAVアンプなどを用意しないと再生をすることができない。

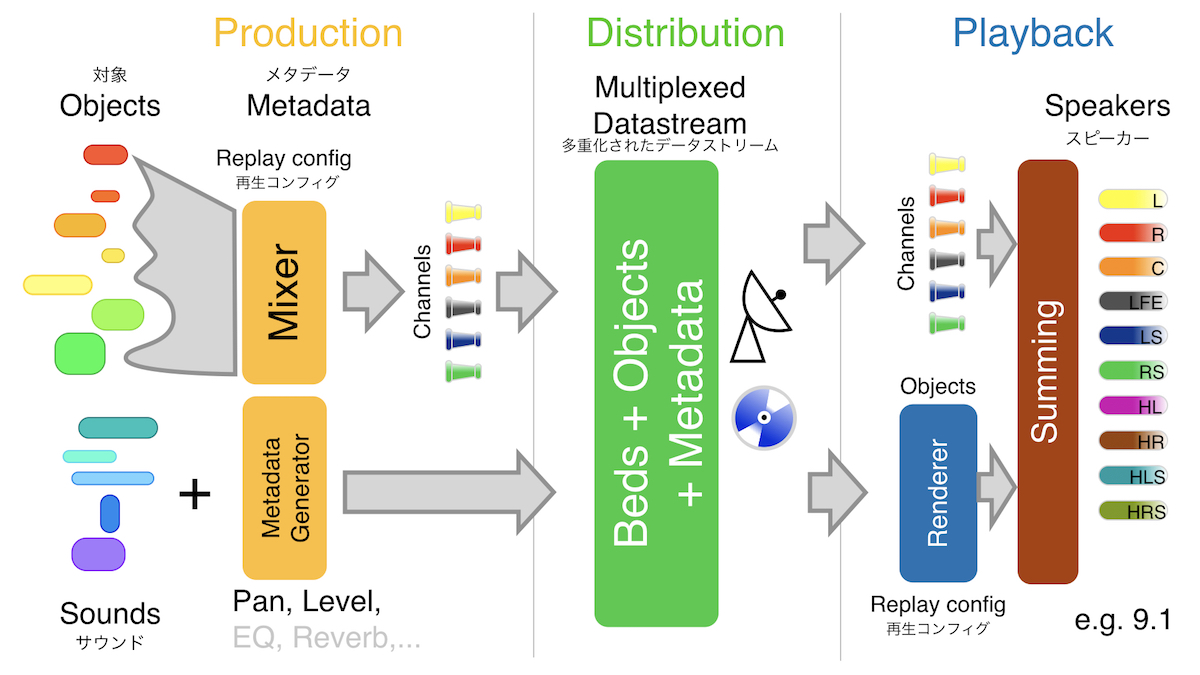

【A+B】ハイブリッド

【A】チャンネル・ベースと【B】オブジェクト・ベースを合体させたハイブリッド・タイプ。多くの商用フォーマットはこのハイブリッド形式を採用している。

まず、作品の中で静的な音(BGMや環境音など)は、チャンネル・ベースとして事前に決めたスピーカー配置に基づいてデータを作成。そして動的な音(ヘリコプターや車、効果音など)は、オブジェクト・ベースとして、オーディオ・ファイルとメタ・データを別で保存する。

配信の段階では、【A.ステムにまとめられたオーディオ・データ(Bedsと呼ぶ場合もある)】+【B. オーディオ・ファイル+メタ・データ】という形でデータが配信される。再生段階でユーザーが視聴環境(スピーカーレイアウトなど)を選択し、オブジェクト・ベースの部分がこの段階でレンダリングされた後、チャンネル・ベースの音声とサミングされ、各スピーカーへと送られる。

このチャンネル・ベースとオブジェクト・ベースのそれぞれ良い部分をハイブリッドして使用するこの形式は、Dolby AtmosやAuro-3D(Auro-Max)、DTS:Xなど多くの商用フォーマットで採用されている。

オブジェクト・ベースの利点

「オブジェクト・ベースの利点は、一言で言うと、その柔軟な『適応性』にある」とフローリアン氏は語る。

例えば、mp3で有名なドイツのフラウンホーファー研究機構が開発する「MPEG-H Audio」は、「ユーザーの好みに合わせて自在にミックスを変更できる」というオブジェクト・ベースの利点を生かした規格である。コンテンツのダイアログやオーディエンスのボリュームなどをユーザー自身が好みに合わせてコントロールしたり、言語を複数の言語に自在に切り替えることが可能で、音の取捨選択をユーザー自身が決めることができ、実際に様々な国で標準規格として採用されている。

また、再生環境(リスナーのスピーカー配置)に対して、2ch用/9ch用など複数のミックスを制作する必要がない。一種類のミックスで全ての多くの視聴環境に対応できることも、この「柔軟性」にあたる。

プログラムの変更も可能

オブジェクト・ベースの機能的特徴は、実は、オーディオ以外の部分でも様々な活用が可能だ。

オブジェクト・ベースを利用すれば、ユーザーの状況に合わせて自在にコンテンツのプログラムも変更することができる。例えば45分尺の作品をそのまま視聴するのではなく、追加ストーリーも含む60分尺で鑑賞をしたり、時間の無い時には、ストーリーをかいつまんで15分尺で作品を鑑賞することができる。その時々の視聴環境に合わせて、プログラム自体を調整することもユーザー側で可能となる。イギリスの国営放送BBCでは、この機能を利用したプログラムがすでに採用されている。

つまり、オブジェクト・ベースの仕組みを利用すれば、「オーディオ」だけにとどまらず、様々な「柔軟性」をユーザーに「選択肢・サービス」として提供できるようになる。また、オブジェクト・ベースの機能を全てオーディオに割り当てることにより、よりImmersive(没入感の高い)コンテンツを作ることももちろん可能だ。

基本理論

ステレオフォニー

本セミナーは3Dオーディオ(イマーシブ・オーディオ)がテーマだが、3Dオーディオでの収録を行うにあたって重要な考え方をお伝えするために、まずはステレオ録音の理論からお話ししたい。

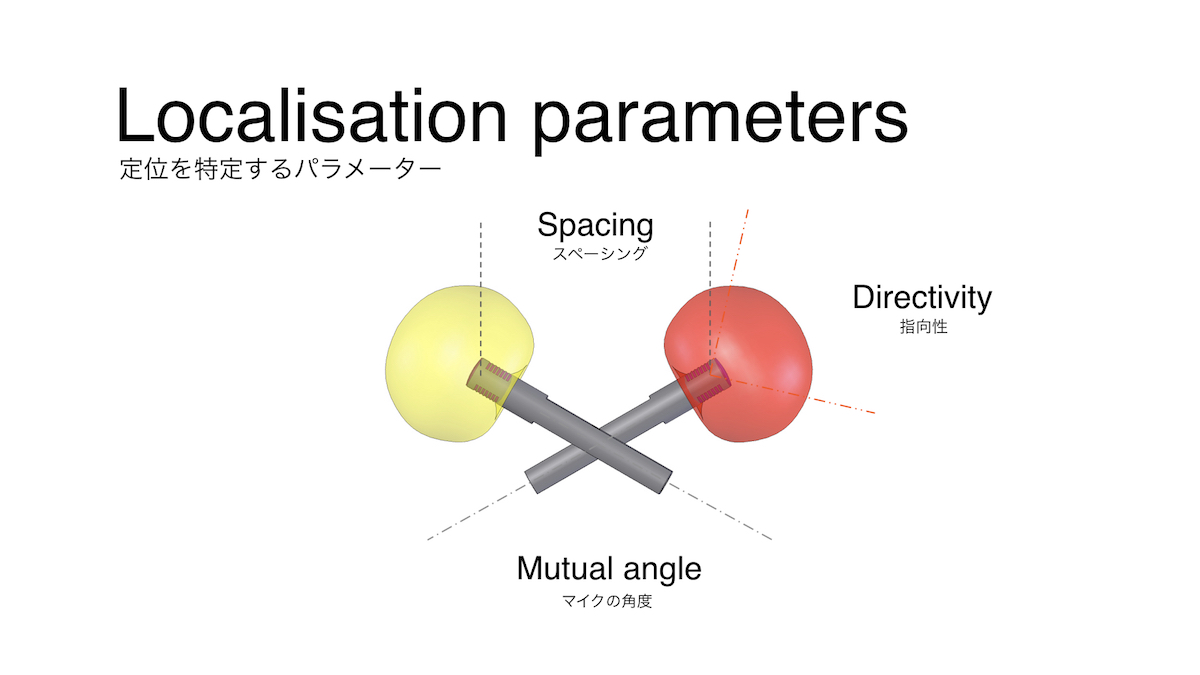

定位を特定するパラメータは、「距離」「角度」「指向性」の3種類。ステレオ録音に際して、結果としてどういった形の録音ができるのかが、この3つのパラメータで決定される。

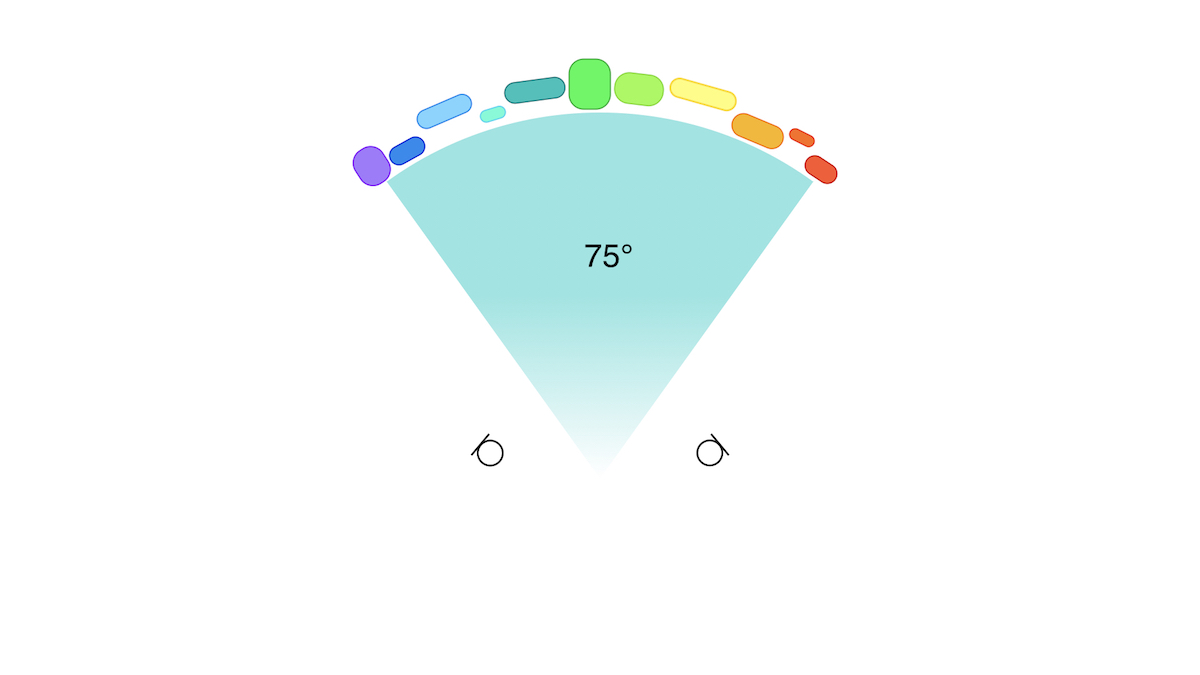

2本のマイクを使用して録音を行うと、目には見えないが、Recordingアングル(録音アングル)というものが発生する。

例えば、75°に配置されたオーケストラの演奏を、75°の録音アングルに綺麗に収めるように録音する。するとリスナーは、そのオーケストラの音を正しく2本のスピーカーの間に聴くことが可能となる。

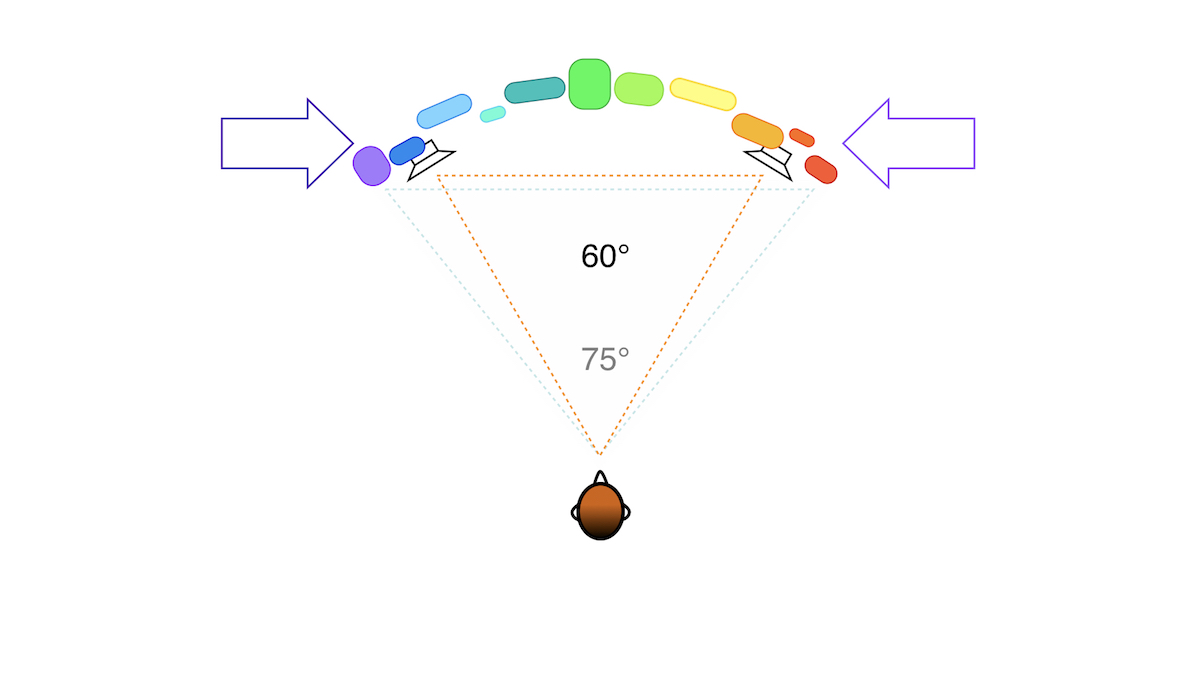

しかし、この「アングル」ができるのは録音時だけではない。再生時には、2本のスピーカーの間にReproductionアングル(再生アングル)が発生するのである。

もちろん、再生アングルはスピーカーの配置角度に従って変化する。例えば、一般的な制作環境でよく採用されているLチャンネル30°+Rチャンネル 30°=60°のスピーカー配置を例にして、先ほどの75°の録音アングルで収録された音源を再生すると一体どのように聞こえるか考えてみよう。

もちろん、再生アングルはスピーカーの配置角度に従って変化する。例えば、一般的な制作環境でよく採用されているLチャンネル30°+Rチャンネル 30°=60°のスピーカー配置を例にして、先ほどの75°の録音アングルで収録された音源を再生すると一体どのように聞こえるか考えてみよう。

上の図のように、音像は、左右からぎゅっと圧縮され再生される。

もちろん各楽器の配置などは相対的にキープされたまま、音像だけが少し圧縮され2本のスピーカー間に収まる形になる。これが例えば180°の録音アングルで録音された音源の場合は、音像は随分と圧縮されて再生されてしまうことになる。

では、どうすればこの問題を解決できるのか。

答えはシンプル。録音アングルを再生アングルに合わせて調整すれば良いのである。

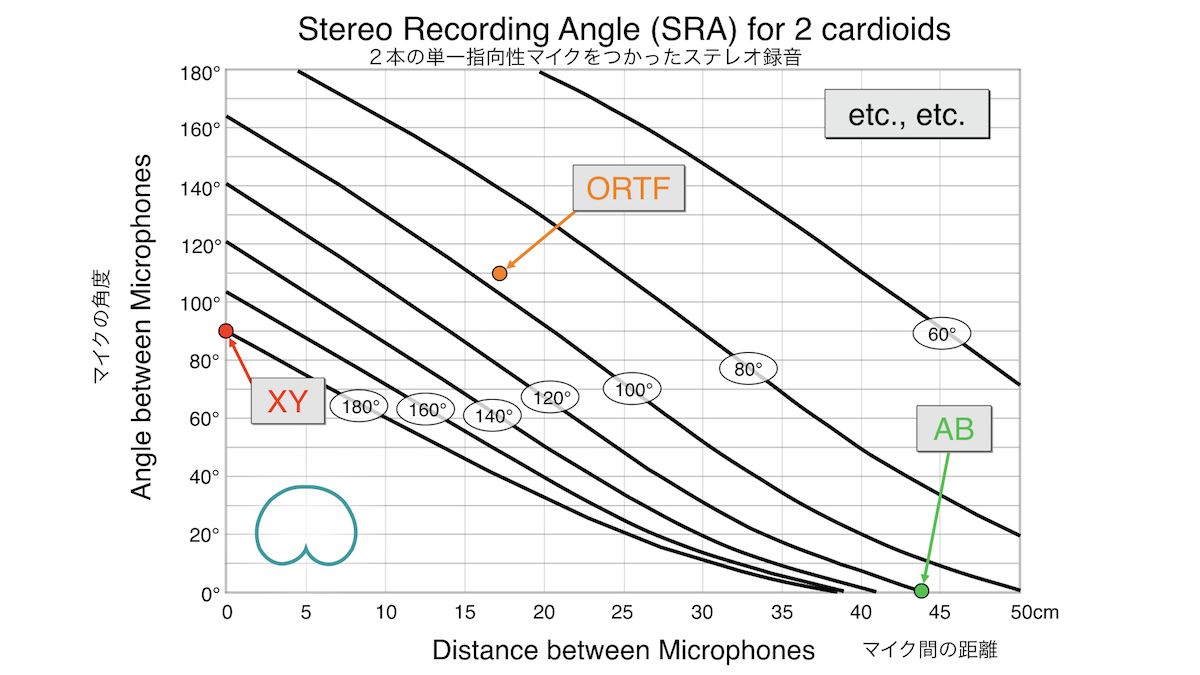

そこで登場するのが、この「ウィリアム曲線」だ。

「スイートスポットの王様」と呼ばれるウィリアム氏(スコットランド)が考案したグラフ。上の図は2本のカーディオイド・マイクを用いたステレオ録音の曲線だ。横軸は「マイク間の距離」、縦軸は「マイクの角度」を示している。

例えば有名なORTFのマイキングシステムは「距離17cm/角度110°」。これで、100°に近い録音アングルが生まれるのである。同じように、XY方式は「0 cm/90°=録音角180°」。対してAB方式は「約45 cm/0°(平行)=録音角120°」。距離が狭いほど録音アングルは広くなる。

上記を踏まえ、マイク間の距離と録音角を調整すると、録音時/再生時の角度が一致するのである。

サラウンド

この録音アングルと再生アングルの角度を一致させるという概念は、音楽の録音においてはあまり重要視されないことが多いが、サラウンドのフィールド・レコーディングの場合、非常に重要なファクターとなる。録音アングルと再生アングルの角度を一致させないと、鳥や車、風など動く音像を捉える場合、スピーカー間を動く音像のスピードが変わってしまうのだ。

まず、録音アングルと再生アングルの角度を一致させた場合、実際の音とスピーカーから再生された音像のスピードがどのように変わってくるのかを、次のアニメーションで見ていただきたい。

マイクロフォンが、再生時のアングルに完全に合致するように真ん中に配置されており、その周りをハチが一定のスピードで正確にマイクの周りを一周したとする。内側の紫色のボールはこのハチの動きを表しており、外側の黄色のボールは、再生時にスピーカーから聞こえてくるハチの音像である。

アニメーションがスタートすると、黄色のボールと紫のボールが一緒のスピードで移動することがわかるだろう。つまり、ハチの飛行スピードが、再生時に正確に再現されたことになるのである。

対して、録音アングルと再生アングルの角度が一致しない場合は、どうなるのか。これもアニメーションで見てみよう。

スピーカーで再生した時、ハチの飛んでいるスピードが、実際のスピードに対して極端にスローになったり、逆にすごく速くなったりするのが見て取れると思う。これではリアルな録音にはなり得ない。特にフィールド・レコーディングにおいて録音アングルと再生アングルの角度を合わせることが重要なのは、こういった理由によるものなのである。

そこで、カメラー氏は一体どのように工夫を重ねてきたのか。

ここから、カメラー氏が歴代使用してきたマイク・アレイの紹介となる。

2D Arrays – 5.0chマイク・セットアップ

目標

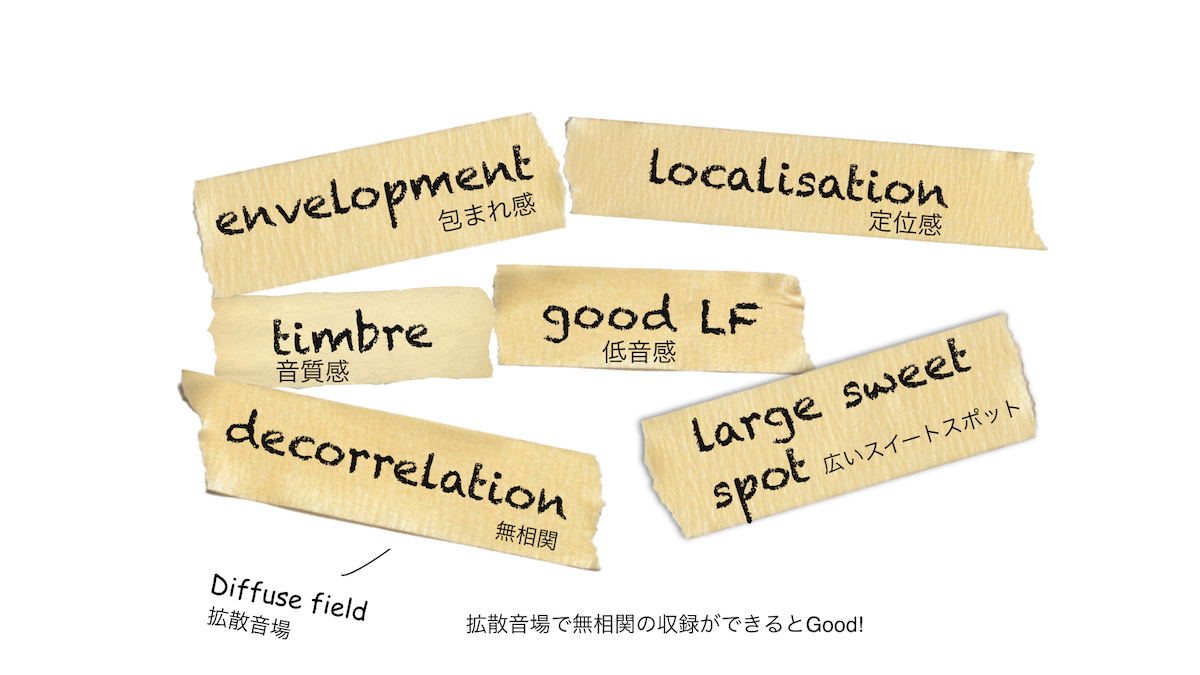

2Dのマイキングを紹介するために、サラウンド・レコーディングの目指すゴールについてお話ししたい。主に以下のような項目だ。

上記の項目が大方得られている録音ができれば、その録音は良い録音になっていると言えるだろう。

「包まれ感」や「音質」は当然重要な項目であるが、「低音感(良い低音)」も非常に重要だ。特にDiffuse Field(拡散音場)においては、無相関で録音できているとさらに良い。

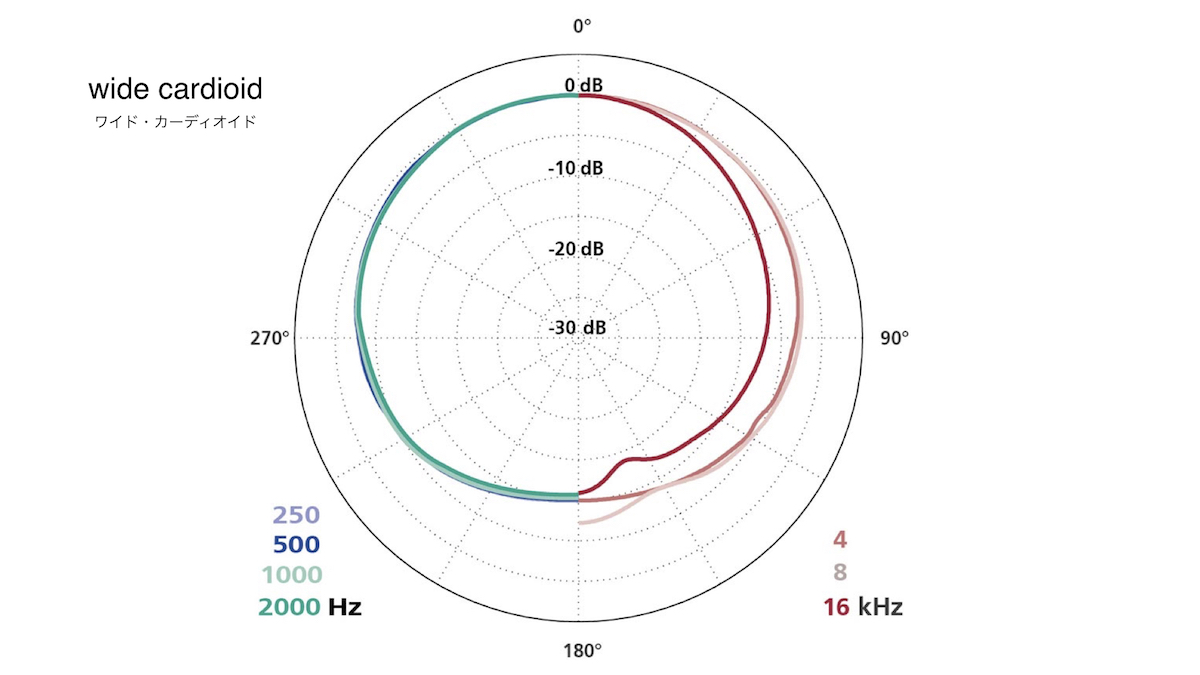

より良い低音を得るには、無指向性マイクが必要となる。ただし無指向性マイクの場合は、欲しくない音を拾ってしまうこともある。そのためカメラー氏は、無指向性ではなくワイド・カーディオイドのマイクを現場で使用している。

なお、「定位感」と「広いスイートスポット」は相反する項目となるため、録音の目的によってバランスが必要だ。つまり、定位感を強くすればスイートスポットは狭くなるし、スイートスポットを広くしようとすると定位感は薄れる……という具合だ。

ということで、上記を満たすマイク配置として、カメラー氏は「ワイド・カーディオイド・マイクを使い、マイク間の距離は広め」がベストだと考えている。

それを踏まえ、彼が挑戦してきた歴代のマイク・アレイが3種類紹介された。

【1】ポリヒムニア(Polyhymnia)

フィールド・レコーデングを始めた頃(25年ほど前)、最初に挑戦したマイク・アレイがこの「ポリヒムニア」である。無指向性のマイク5本からなるセッティングだ。

このマイク・アレイは、後ろのサラウンド用のマイク間の距離が広すぎた。フィールド・レコーディングを行ったところ、包まれ感は良かったが、後ろ側の2つのマイクの距離が広すぎるため「ダブル・モノ」状態になり、スピーカーで再生した際に、後ろの2本のサラウンドスピーカーの間で「中抜け」現象が発生してしまった。

なお、ウィリアム曲線をまだ知らなかった初期の頃の配置である。

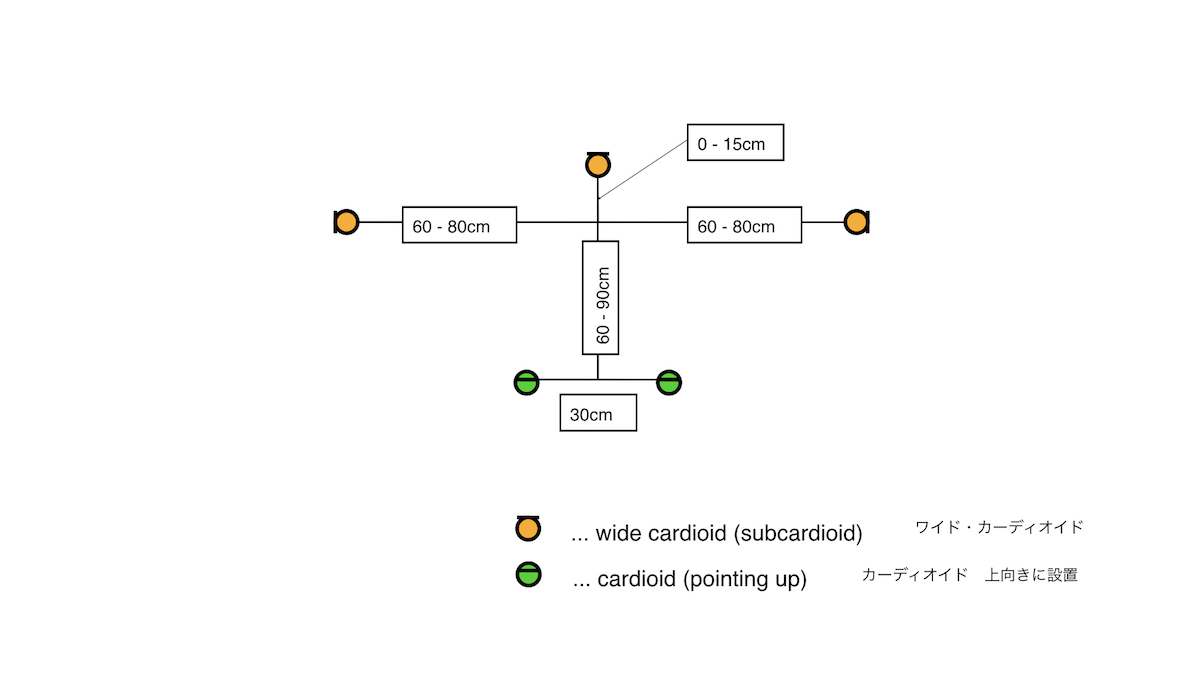

【2】Corey-Martin Tree(コーリー・マーティン・ツリー)

ポリヒムニアの短所を改善すべく次に挑戦したのが、「コーリー・マーティン・ツリー」である。コンサートホール用での収録用として考案されたこのマイク配置。フロント3本はワイド・カーディオイド。リア2本はカーディオイドで、天井を狙って上向きに配置している。

リアの2本の上向きのマイクで天井からの響きを収録するようにデザインされているのだが、フィールド・レコーディングでは「天井」がないため、カメラー氏はリアもワイド・カーディオイドに変更。上向きではなく、フロント同様に外向きの配置にした。

このマイク・アレイは、録音アングルと再生アングルが一致していることが特徴で、前回の距離の問題は解決した。しかし、マイクを1つ1つウィンド・ジャマー(風防)で覆っていることで、一方向からの突風の吹かれが 「見え」やすくなるという問題が新たに発生した。つまり、特定のスピーカーだけが大きな吹かれ音を出すことにより、スピーカーがリスナーに「見え」てしまうようになり、そして、そのことにより最も大切な没入感が薄れてしまうという問題だ。

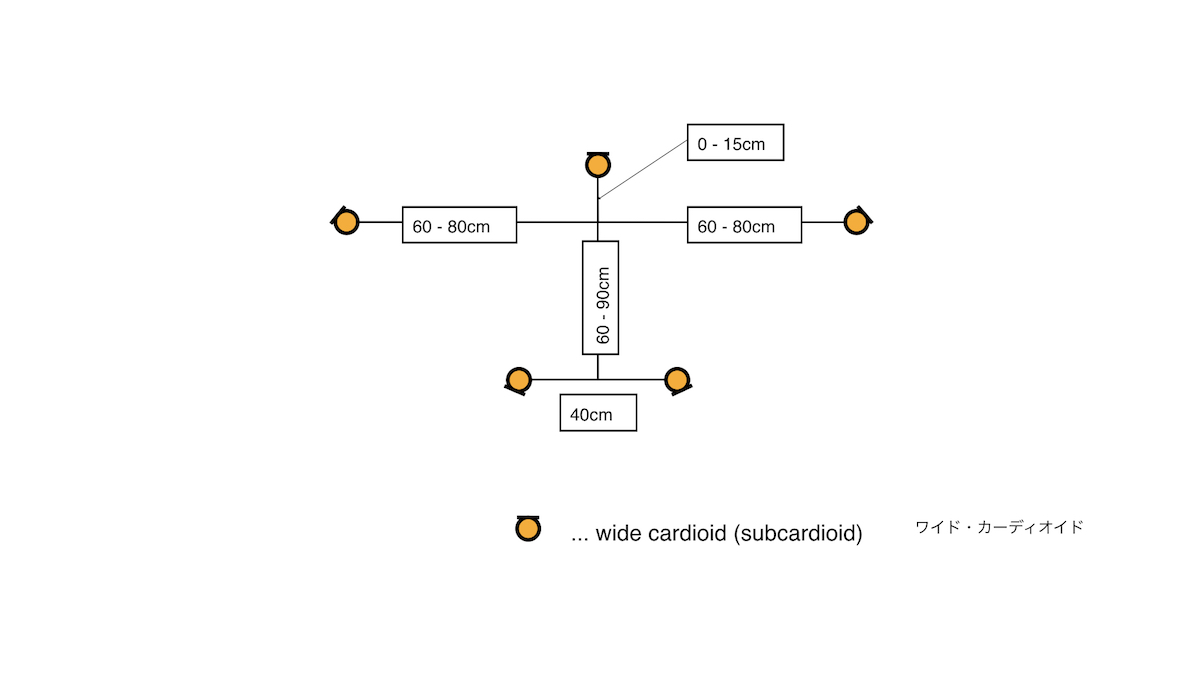

【3】UFIX(ユーフィックス)

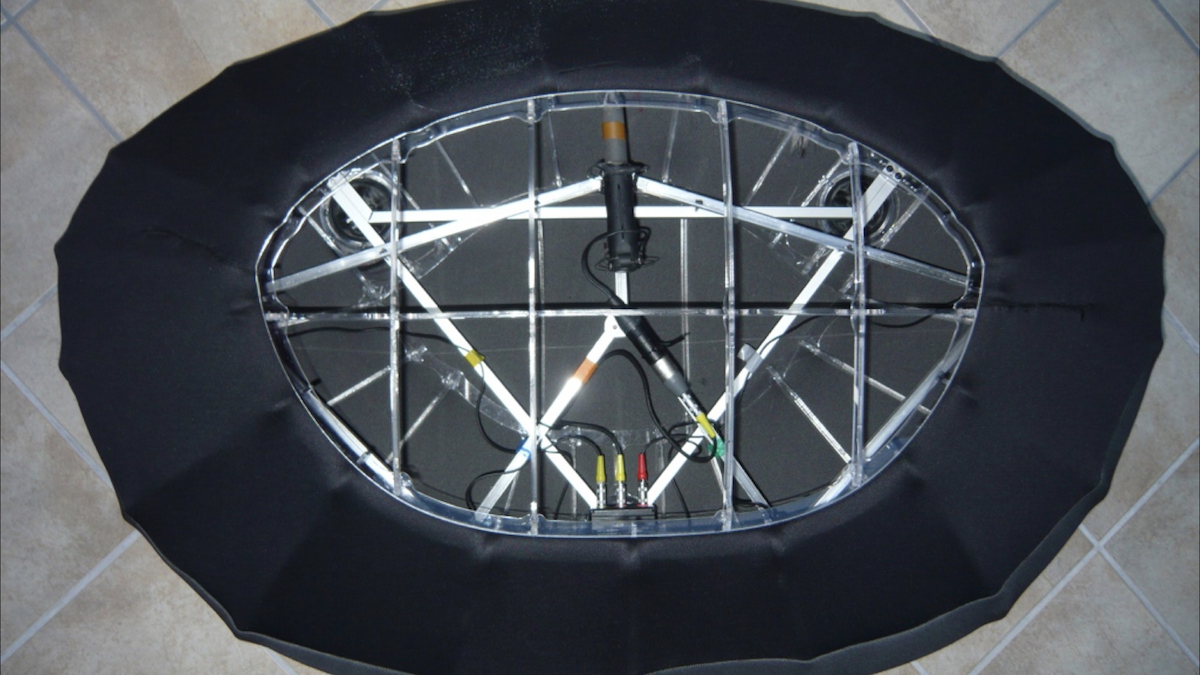

そして生まれた第3のセッティングが「UFIX」だ。「1つの大きな風防にマイク全体を納めてしまえば解決するのでは」という発想から生まれたマイク・アレイである。

大きな風防の製作は、フランスのフィリップ氏に依頼した。

UFIXは、一つの大きな風防の中に、「コーリー・マーティン・ツリー」を改良した、5本のワイド・カーディオイドのマイクとコネクタが入っているセッティングとなっている。

2Dサラウンドでのマイク・アレイのご紹介はここまで。さて、いよいよ今回のセミナーの主題である「3Dサラウンド」、つまりイマーシブ・オーディオでのマイク・アレイを紹介する。

3D Arrays – 9.0chマイク・セットアップ

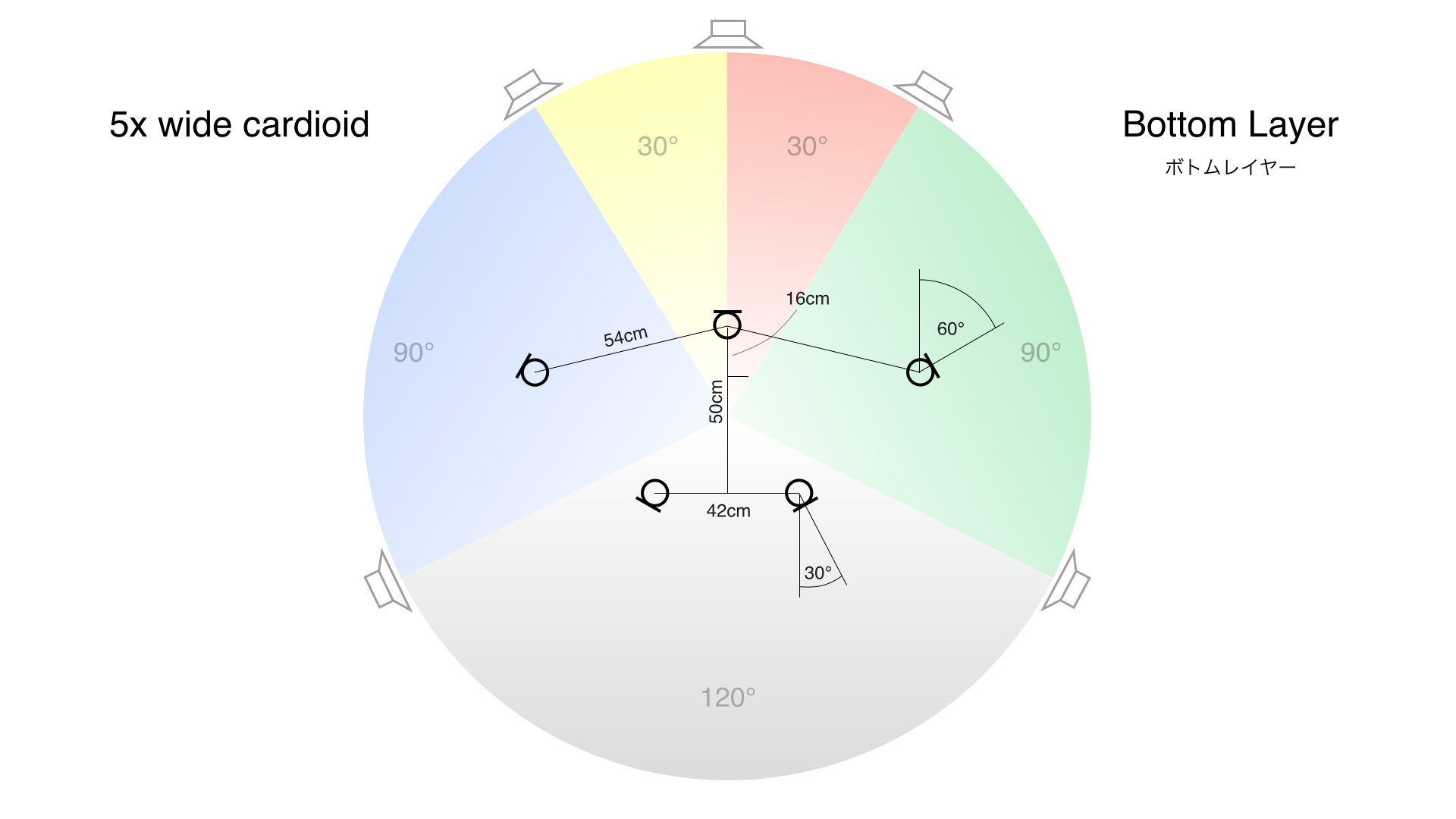

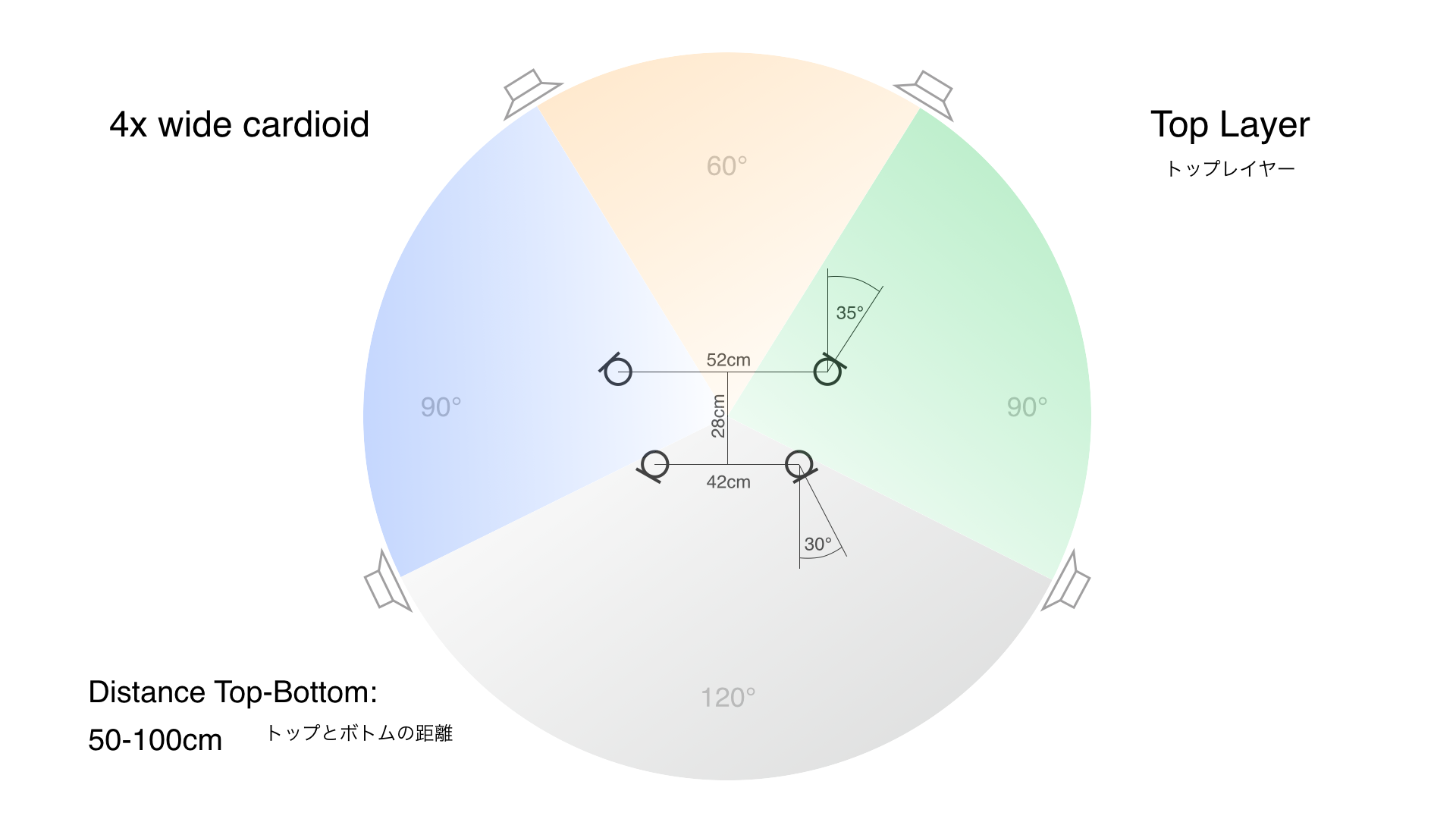

3Dサラウンドの録音にあたっては、先程の「UFIX」を2つ重ねた、9.0chのマイク・アレイ「ダブルUFIX」を採用した。ボトムに5つ、トップに4つのワイド・カーディオイド・マイクが、それぞれ録音アングルと再生アングルを合わせて配置されている。

もちろん、縦方向においても、録音アングルと再生アングルを一致させる必要があり、トップとボトムそれぞれのマイクの角度を正確に合致させることで、音像に正確な立体感が生まれることになる。風防を除いた骨組みは下記の通りだ。

本セミナーの会場では、カメラー氏が、歴代どのように考えマイク・アレイを進化させてきたかの説明に伴い、それぞれのマイク・アレイで実際に収録した録音が再生された。特にDouble UFIXでの録音については、「まるでスピーカーの向こう側に世界が広がっているかのようでしょう」というカメラー氏の言葉通り、素晴らしい没入感だった。

シーン・ベース(Ambisonics)

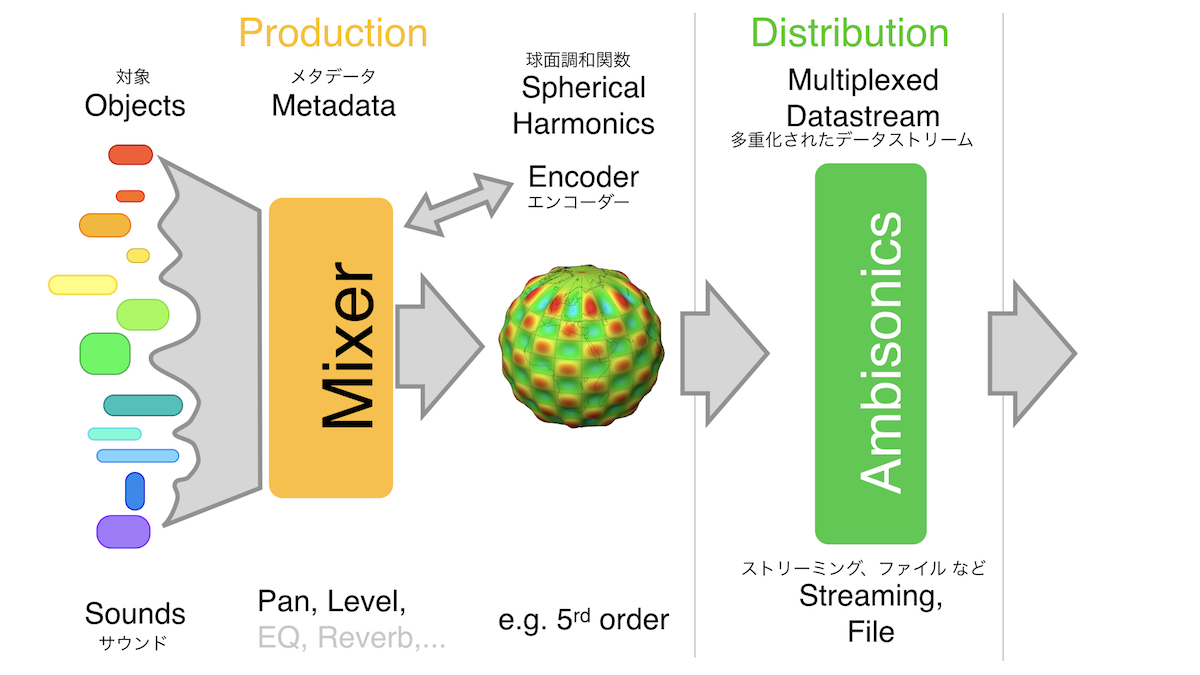

さて、目次の最後の項目「シーン・ベース」について紹介する。

シーン・ベースは一般的に「Ambisonics(アンビソニックス)」と呼ばれており、1970年にはすでに確立されていた理論である。シーン全体を球面で捉える方式で、ここ数年のVRブームで急速にメジャーになった。

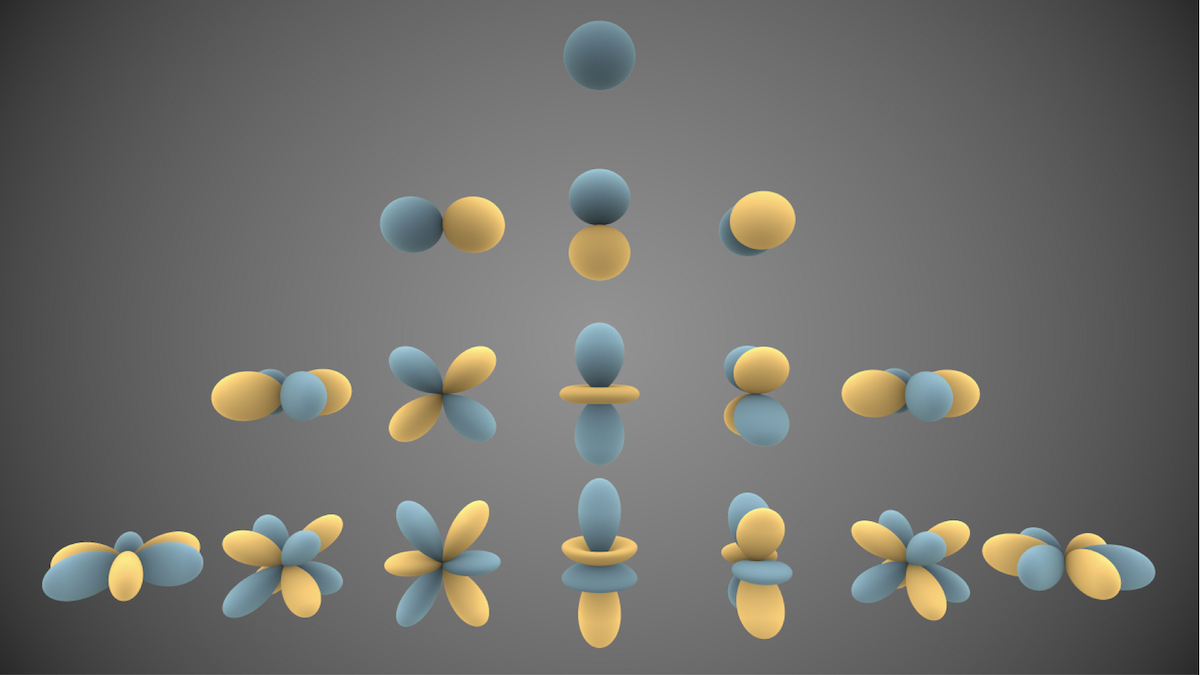

録音の対象物であるサウンドを収録してミックスする際、チャンネル・ベースやオブジェクト・ベースとは異なり、Ambisonicsでは「エンコード」が必要となる。そして、エンコード処理に「球面調和関数」が使われるのも特徴だ。球面調和関数は、数学や物理の世界ではよく使われるため、耳馴染みがある用語だと感じる方もいるだろう。

球面調和関数でエンコード処理を行った音源は、360°全天球の音場にプロットされるのだが、この際、全天球の音場を「シーン」として捉えるため「シーン・ベース」というワードで表現されるというわけだ。

ちなみに、Ambisonicsは、First Order(一次)から、Second Order(二次)、Third Order(三次)と、次数をどんどん高めてゆくことが可能である。これら高次のAmbisonicsは、HOA -High Order Ambisonics-(高次アンビソニックス)と呼ばれており、理論的には次数はいくらでも上げることができる。球面調和関数と高次アンビソニックスについては、少し詳しい説明を後ほど行うが、ここではまず、Productionステージにおいて球面調和関数を使ったエンコード処理が必要であるということをご理解頂きたい。

Ambisonicsフォーマットにエンコードされたファイルは、通常のインターリーブのWAVファイル形式である。そのためDistoributionステージでは、このオーディオ・ファイルをリスナーの待つPlaybackステージへと様々な方法で伝送することが可能だ。

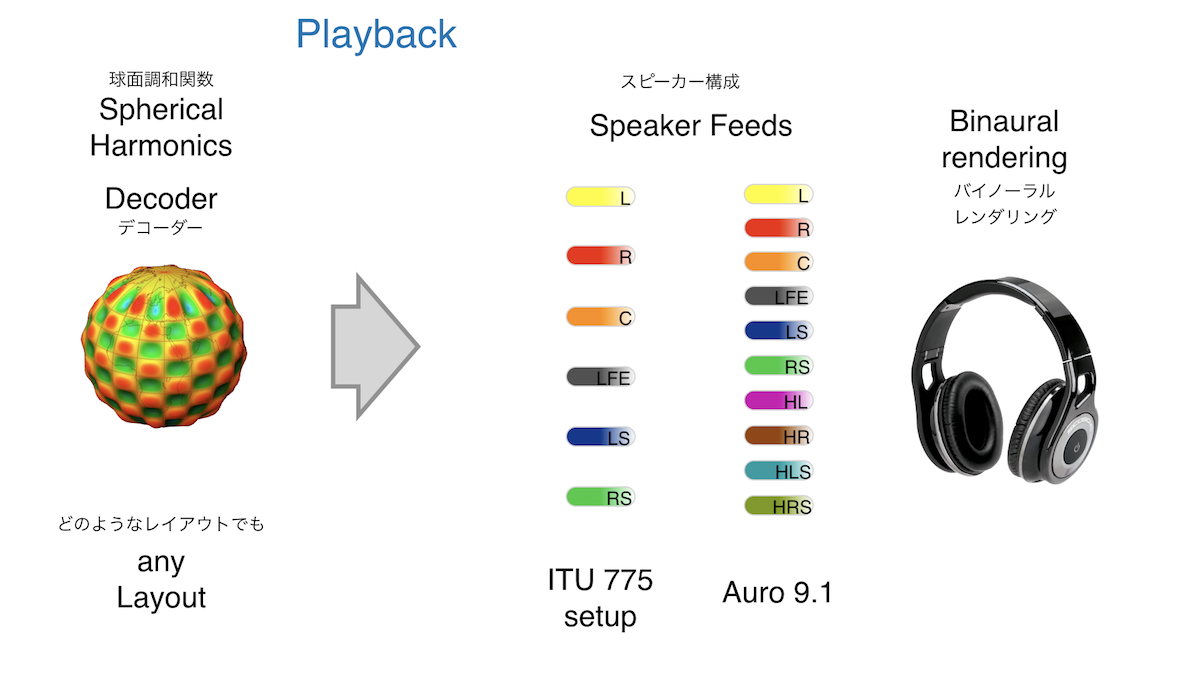

そして、リスナーの手元に届いたAmbisonicsファイルは、Playbackステージにおいてデコードされることになる。

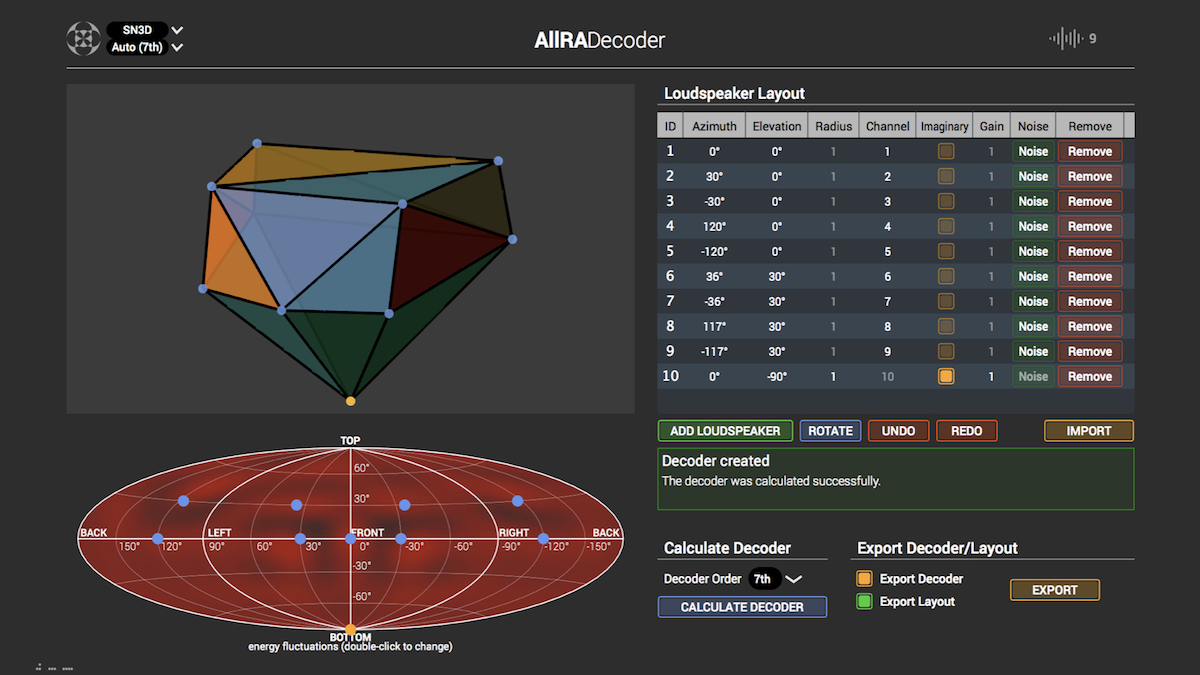

デコードの段階で、どのようなスピーカー・レイアウトにも対応させられること、これがAmbisonicsのもう一つの大きな特徴である。先述のオブジェクト・ベースもどのようなスピーカー・レイアウトにも対応できると説明したが、実際にはDolby Atmosなどもチャンネル・ベースとのハイブリッドの規格のため、5.1.4/7.1.4といった、ある程度事前に決められたスピーカー・レイアウトが存在する。その反面、Ambisonicsは、一切スピーカー・レイアウトに依存しない。文字通り「どのようなレイアウトでもOK」なフォーマットなのである。

したがって、既存のDolby Atmos(5.1.4/7.1.4他)/Auro3D(13.1他)/NHK(22.2ch)などはもちろん、アトラクションやインスタレーションなど変わった配置が求められる場所にも、柔軟かつ簡単に対応することができる。これはつまり、再生段階でどのようなスピーカー・レイアウトが待っていても、制作段階で作るミックスはたった1種類で良いということだ。Dolby Atomos用ミックス、Auro3D用ミックス、22.2用ミックス、ヘッドフォン用ミックス……と異なる数種類のミックスを作る必要がないため、制作のコストを大幅に抑えることができる。これが、おそらくAmbisonicsの最大の特徴(長所)になるだろう。

もちろん、バイノーラル・エンコーディングを行えばヘッドホンでの視聴も可能だ。

そして最後に、ヘッドフォンでの再生に関するAmbisonicsの特徴をもう1つ紹介したい。Ambisonicsは、その全球体の球体面にエンコードさせた音の動き……動かない音も動く音もすべて、球体ごと自由に回転させることが簡単にできる。これが、ずばり冒頭で紹介した、VRブームでAmbisonicsが急速に脚光を浴びることになった理由である。

球面体を自由に動かせることにより、VRのゴーグルを装着し、完全没入型のコンテンツを体験している時に、右や左を見た際に音だけが本来コンテンツ内にて発音されている位置から動かずにいられる……つまり裏を返して言えば、音像は、ゴーグルの動きとは逆方向に自動的にパンニングされているということになる。Ambisonicsを使えば、全ての音の相関関係を保ったまま、その球体面全体を簡単に素早く回転させることができるため、VRの音声には最適なフォーマットなのである。

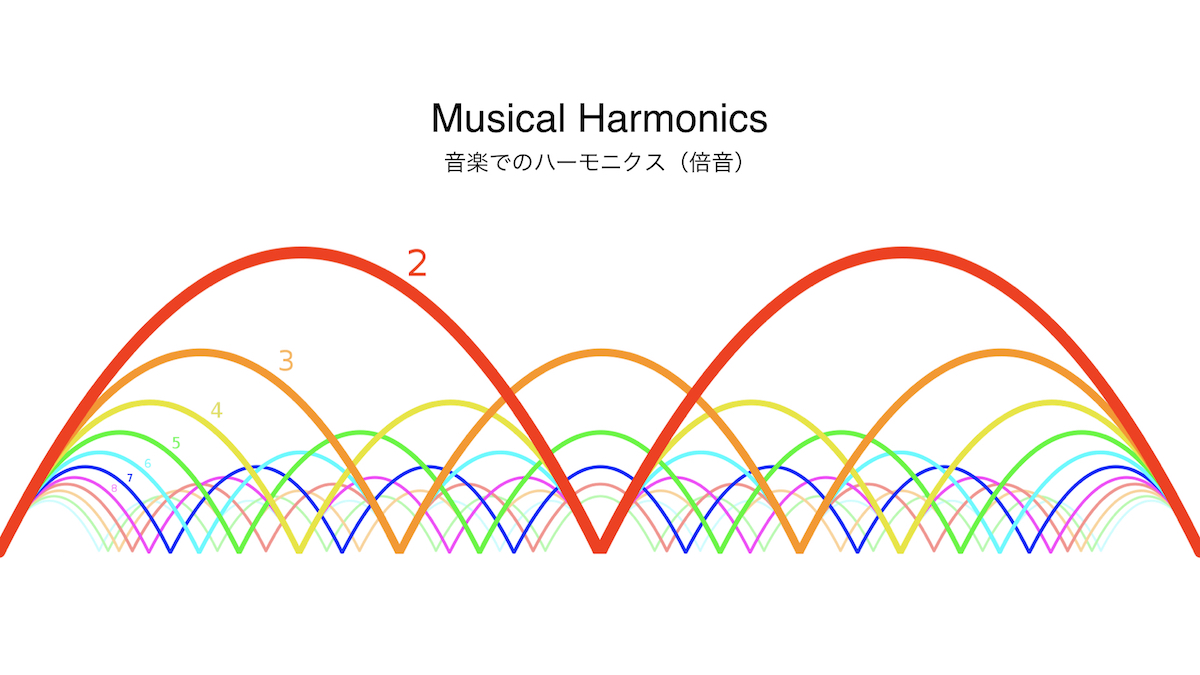

球面調和関数

Ambisonicsのエンコードに関わる球面調和関数は、音の倍音と非常によく似た性質だ。倍音(周波数ベースのハーモニクス)は、基音+2次、3次……と足されるにつれて、音色のキャラクタがよりはっきりとする。

Ambisonicsは、A-formatからB-formatにエンコードする際に次数を選択することができ、次数が大きくなればなるほど解像度が上がる仕組みだ。0次を無指向の1chとし、1次=4ch、2次=9ch……と増え、理論的には無限大まで増やすことが可能。計算上などの制約から、2019年現在では7次Ambisonicsが実用上の最大値とされている。

Ambisonics専用マイク

昨今、複数のメーカーから様々なA-format アンビソニックス・マイクがリリースされいている。

カメラー氏は「Ambisonics専用マイクは、とても便利だけど必ずしも必要なわけではない。『なんでも』アンビソニックス化することが可能なんだ」と強調。モノマイクから大型のアレイまで、モノラルでも、ステレオでもマルチチャンネルでも、オーディオファイルであれば、次のプラグインで全てアンビソニックス化できると語った。

IEM Plug-in Suite

オーストリア・グラーツ大学のダニエル・ルードリッヒ率いるチームが開発したプラグイン・バンドルセット。

複数のエンコーダーやシェイパー、デコーダーなど様々なプラグインが含まれ、なんとオープンソース。コードも公開されており利用も無料のため、誰でも今日から使うことが可能である。

以上でカメラー氏のワークショップが終了。「Hurra!(ばんざい!)」と書かれたスライドで、セッションが締めくくられた。

使用機材