2023 / Session 2

イマーシブオーディオ対応のスタジオをGenelecで作ってみた

〜作ってみたからこそわかる知見とノウハウ〜

MI7グループ主催のセミナーイベント「Media Innovation Workshop | ONLINE」。2023年の第2回目は、可能な限り正確なモニタリングができるような環境を整えるための知見やノウハウを共有するワークショップです。

ゲームの世界ではイマーシブオーディオ(立体音響)を意識した音作りがすでに一般化していますが、音楽への応用はまだ始まったばかり。

一部意欲的な作品が、空間オーディオとしてリリースされていますが、まだまだ試行錯誤が続いている過渡期とも言える状態かと思います。

ヘッドフォンで気軽に聞けるようになったことが普及のきっかけとなったイマーシブオーディオですが、制作においては、実際のスピーカーでのミックス確認がほぼ必須の状態。

ということで、今回は…

「Genelecスピーカー使って実際にイマーシブスタジオを作ってみた!」

と題しまして、ゲーム業界では知らない人のいない株式会社 CRI・ミドルウェアにて音響エンジニアリング・マネージャーを務める本間清司氏、そして、株式会社ツーファイブのエンジニア/ディレクター、太田 将義氏にご登壇いただき、ゲームサウンドや音楽制作者において、可能な限り正確なモニタリングができるような環境を整えるための知見やノウハウを共有するワークショップを皆さんにお届けいたします。

セミナー概要

| シリーズ | Media Innovation Workshop | ONLINE 2023 |

| 講演タイトル | イマーシブオーディオ対応のスタジオをGenelecで作ってみた 〜作ってみたからこそわかる知見とノウハウ〜 |

| 配信日時 | 【終了】2023年10月3日(火) 17:00 – 18:30 |

| 視聴方法 | Zoom (現在アーカイブ準備中) |

| 料金 | 無料 |

イマーシブオーディオ対応のスタジオをGenelecで作ってみた

〜作ってみたからこそわかる知見とノウハウ〜

本ワークショップでは以下の情報が得ることができます

Dolby Atmosのチャンネル数に関しての解説

なぜたくさんのスピーカーが必要なのか?

ファントムセンターとハードセンター

▶️ イマーシブ対応スタジオ構築事例 ースタジオを作ってみたー

Atmosスタジオの指標

部屋の大きさ 音圧など

遮音、床荷重、静粛性

単管パイプでGenelecを賃貸物件に組む!

▶️ ハードウェア機器の選定とチューニング

Dolby Atmos制作機器、基本セットアップ

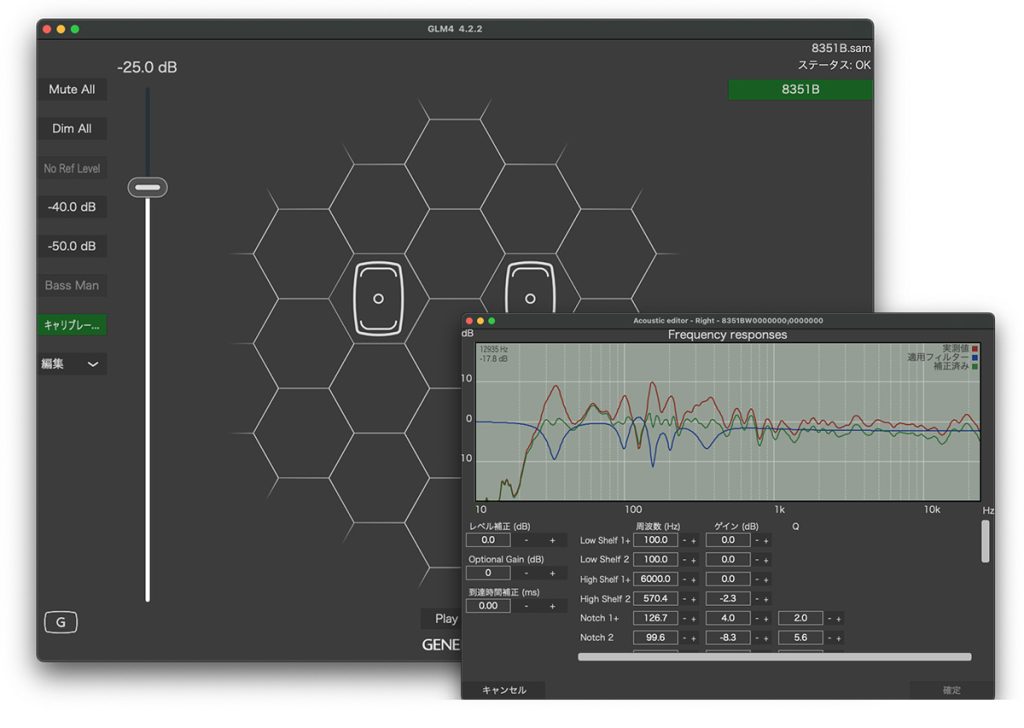

GLMのモニターコントロール機能の活用

▶️ アコースティックチューニング

GLMのGRADEレポートの活用

▶️ イマーシブオーディオコンテンツ制作 ーコンテンツも作ってみたー

ミックス作業時の環境

ミックスダウンからデリバリーまで

▶️ Dolby Atmos Musicの制作例 ー音楽コンテンツも作ってみたー

実際の作品を、2chバイノーラルにてお届けします。

注意:ご視聴の際は、必ずPCよりヘッドフォンを使用してワークショップヘご参加ください。

(スマホ環境の場合、ZOOMの仕様により音声をステレオにて楽しむことができません。ご注意ください。)

なお、当日は、本間氏のワークショップに続いて、先日アムステルダムにて開催された世界で最も刺激的なコンテンツとテクノロジーのイベント「IBC 2023」にて発表されたGenelecの新製品に関しても皆さんと情報を共有いたします。

どうぞお楽しみに!

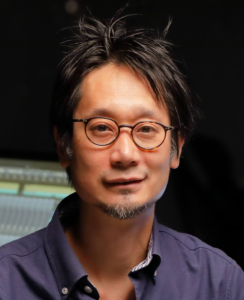

本間 清司 (Seiji Honma)

本間 清司 (Seiji Honma)

株式会社 CRI・ミドルウェア

音響エンジニアリング・マネージャー

1997年 avex社からリミックスアルバムをリリース

1999年 東京理科大学大学院 工学研究科 卒業

同年 SEGA AM2にサウンドツールエンジニアとして入社

2009年 CRI Middleware, Inc. 入社

CRIではサウンド関連の技術営業を行いつつ空間音響の研究に携わり、メジャーレーベル向けのリミックス・エンジニアとして300タイトル以上の作品に関わり続ける。

太田 将義 (Masayoshi Oota)

太田 将義 (Masayoshi Oota)

株式会社ツーファイブ

エンジニア/ディレクター

日本工学院専門学校 卒業後、ゼロスタジオに入社。

スタジオ・エンジニアとしてメジャーアーティストものからCM、サウンドトラック等のレコーディング・ミックス業務も経験した後、2009年に株式会社CRI・ミドルウェアのグループ会社

同社ではゲームボイス収録、編集、楽曲制作、ディレクションなどを担当。

携わった作品数は 1000を超える。

久保 二朗

久保 二朗 松本 昭彦

松本 昭彦

牛島 正人

牛島 正人 蓮尾 美沙希

蓮尾 美沙希

及川潤耶

及川潤耶

濱﨑 公男

濱﨑 公男 亀川 徹

亀川 徹 入交 英雄

入交 英雄 細井 美裕

細井 美裕 蓮尾 美沙希

蓮尾 美沙希